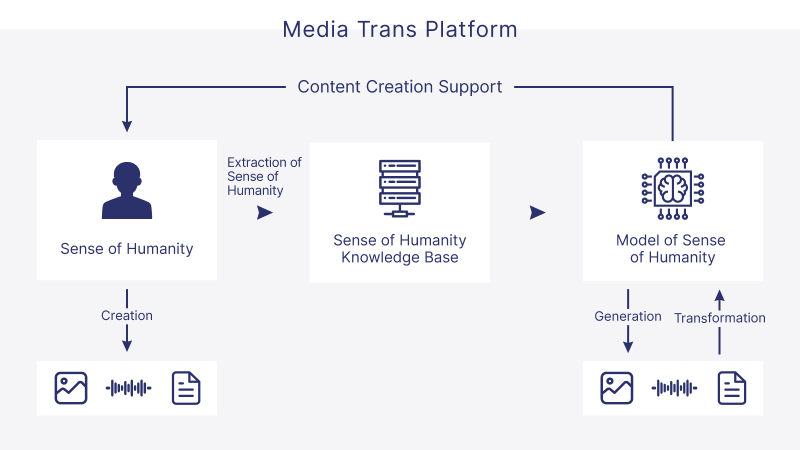

MediaTrans Platform

人間のセンスによりこれまで我々は音声、画像、テキストなどのメディアを使ってさまざまな作品を創造してきた。楽曲、絵画、写真、映画、小説などがそれにあたるだろう。これらの人間のセンスをデータ化し、人間のセンスのモデルを作ることにより、単に人間の創作活動を助けるだけでなく、これまでインタネット上に散在してきたメディアコンテンツを消費する人間がさまざまなメディアに変換し、新たな作品を作ったりすることができる。マルチモーダル生成AIの台頭で自動的にさまざまなメディアを横断したメディアコンテンツの生成が可能となっているが、我々は、生成だけにとどまらず、人間の創作活動やメディアを自由に変換できる機能をもつMediaTrans Platformの実現を考えている。

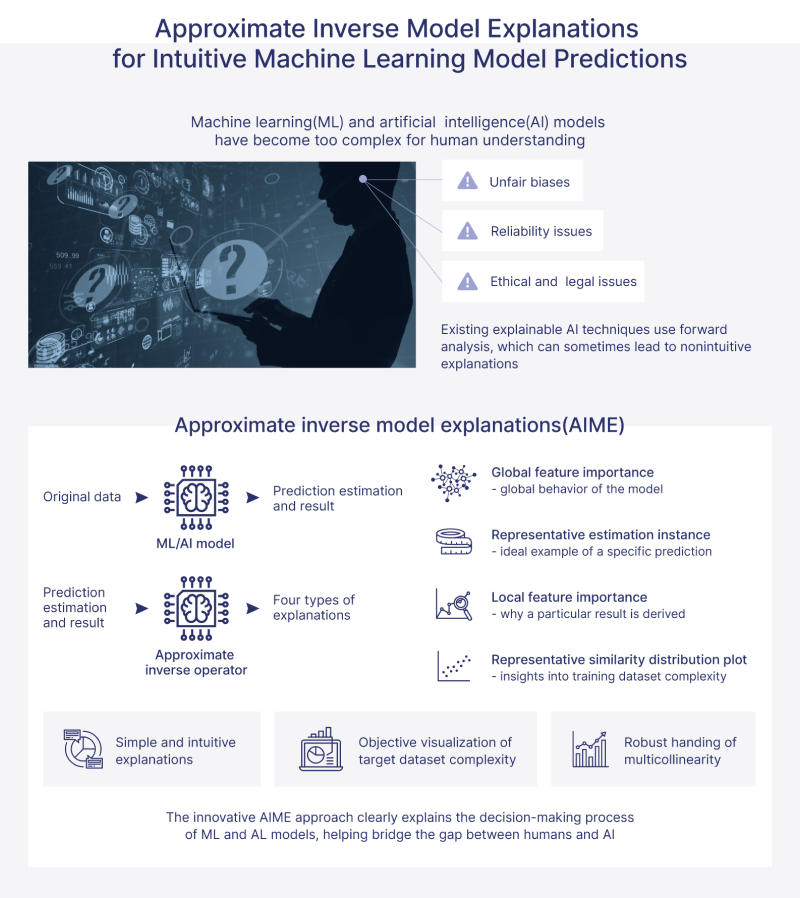

Explainable AI-AIME

現在の複雑なAIや機械学習によるモデルは、ブラックボックスモデルであり、なんらかの問題に対して推定結果を導出することが可能であっても、なぜそのような推定結果を導出したのかという説明を示すことが難しくなっており、Explainable AI(XAI)の重要性が言われている。また、今後AIは公平で説明可能で透明性が高いことが求められ、これらを技術的な側面から解決する一つがXAIと考える。我々は、独自のApproximate Inverse Model Explanations―AIMEを提案し、他の手法より計算量が少なく、シンプルで解釈可能な説明をブラックボックスモデルの近似逆作用素を導出することにより実現する。これらにより、モデル全体としての振る舞いを表すGlobal feature importance、データインスタンスごとの推定根拠を説明するLocal feature importanceを計算することが可能となり、振る舞いの可視化が簡単に可能となる。またその分類問題が難しいか簡単かを可視化することも可能となる。

我々のゼミではAIMEのアルゴリズムの研究はもちろん、新たな応用についても研究をすすめている。

現在、日本特許登録済(特許第7533997号)、米国出願済み、ヨーロッパ、中国での出願準備中。

Time-series Text Topic Extraction

インタネット上に時間情報のついたコンテンツが散在している。これらのコンテンツからトピックを取り出した上で、もう一度時系列で可視化をすることにより、トピックのトレンドを確認することができる。これにより、我々は、ある事象の世論の変わり目や政府の方針変更など、重要な局面を知ることが可能となる。

Sign Language Recognition/Composition

我々は世界の様々な人々がコミュニケーションデバイドを解決できるようなGlobal communication platform環境の構築を目指している。例えば、手話話者と音声話者との会話では両者が感情を含めたリアルタイムな認識、合成が必要であると考える。我々は手話認識、および手話合成に着目し、単なる手指の動作だけでなく、顔などのNM表現と呼ばれるも含めて実現することにより、感性をリアルタイムに伝えるメディアを実現できる。

その他共同研究

TransMedia Tech Labでは多数の企業様との共同研究を推進しています。